Lấy cảm hứng từ cấu trúc phân cấp của não bộ, các nhà nghiên cứu đang tạo ra một mô hình AI có khả năng chạy tốt hơn, nhẹ hơn, mở ra triển vọng ứng dụng theo thời gian thực trên các thiết bị cá nhân.

Trong khi cả thế giới AI đang hướng sự chú ý vào GPT-5, mọi con mắt dồn vào những mô hình khổng lồ với hàng tỷ tham số, thì tại Singapore, có một nhóm nghiên cứu của công ty khởi nghiệp AI Sapient Intelligence mà ít ai biết tới đang âm thầm làm việc. Họ không sở hữu những cụm máy tính siêu khủng, và cũng không có hàng núi dữ liệu từ toàn bộ Internet như các ông lớn BigTech. Có lẽ vì thế họ đã đi theo một hướng tiếp cận hoàn toàn khác.

Nhóm này, dẫn đầu bởi Guan Wang cùng các cộng sự Jin Li, Yuhao Sun, Xing Chen, Changling Liu, Yue Wu, Meng Lu, Sen Song và Yasin Abbasi Yadkori, theo đuổi một hướng đi lạc dòng: thay vì phóng đại quy mô của mô hình, họ tìm cách dạy cho AI một kiến trúc suy luận phân cấp, lấy cảm hứng từ cấu trúc phân cấp của não bộ, mà họ gọi là HRM (Hierarchical Reasoning Model).

HRM áp dụng hai cấu trúc module hồi quy, bắt chước quá trình lập kế hoạch cấp cao và tính toán chi tiết cấp thấp trong não người. Trong một bản thảo mới công bố trên arxiv hồi đầu tháng 8/2025, các nhà nghiên cứu của Sapient Intelligence tự báo cáo rằng mô hình HRM của họ ghi lại độ chính xác gần như hoàn hảo trong các nhiệm vụ suy luận phức tạp như Sudoku cực khó và giải mê cung - điều mà những mô hình AI sử dụng phương pháp chuỗi suy nghĩ (Chain of Thought) tiên tiến lại không mấy thành công. Đáng chú ý, HRM đạt 40,3% điểm chuẩn trong bài kiểm tra đo lường khả năng suy luận trừu tượng của AI tổng quát (ARC-AGI-1), vượt trội hơn nhiều so với các mô hình lớn hơn như o3-mini-high của OpenAI (34,5%) và Claude 3.7 Sonnet (21,2%).

Sự xuất hiện của mô hình HRM gây chú ý vì nó cho thấy một cách tiếp cận hoàn toàn mới, mang lại hiệu quả vượt trội. Thay vì cần tới hàng trăm tỷ, thậm chí nghìn tỷ tham số như các mô hình ngôn ngữ lớn truyền thống, HRM chỉ với 27 triệu tham số đã đạt hiệu suất suy luận vượt trội. Ngoài ra, mô hình HRM chỉ dùng đến 1.000 ví dụ đầu vào-đầu ra để đào tạo, ít hơn nhiều so với các mô hình AI khác. Trong thế giới AI, nơi mà các phòng lab và công ty công nghệ đang ra sức tăng kích thước bộ dữ liệu, mở rộng sức mạnh tính toán, nhồi nhét thêm tham số với niềm tin rằng “lớn hơn là tốt hơn”, thì sự xuất hiện của HRM hoàn toàn phá vỡ quy tắc này.

Nhờ sử dụng ít tham số hơn, mô hình HRM có tiềm năng chạy độc lập trên các thiết bị có cấu hình không cao, chẳng hạn như các máy tính cá nhân hoặc các thiết bị cầm tay. Tuy nhiên, hiện HRM mới chỉ là mô hình và chưa có sản phẩm thương mại cụ thể được cài đặt để có thể đánh giá khách quan về khả năng này.

Kiến trúc: Tuyến tính và phân cấp

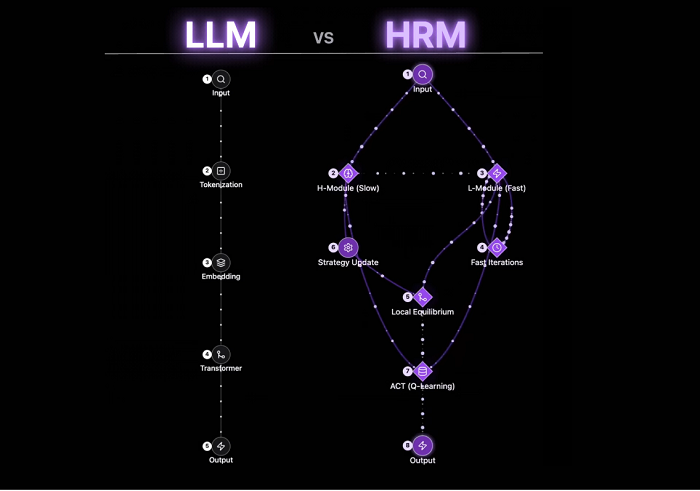

Về mặt kỹ thuật, cấu trúc phân cấp của HRM khác hẳn với chuỗi suy luận tuyến tính (Chain of Thought) mà các mô hình ngôn ngữ lớn (LLM) như ChatGPT và nhiều công cụ AI khác đang sử dụng.

Hình dung LLM giống như một cỗ máy đường ray tốc độ cao: bạn nạp vào một câu hỏi (input), nó chuyển thành các token, nhúng vào vector, chạy qua một khối xử lý Transformer, rồi đưa ra câu trả lời (output). Tất cả diễn ra trong một lần truyền thẳng. Nhanh, mạnh và ấn tượng nhưng chỉ theo một chiều, các mô hình LLM không có vòng lặp tự suy nghĩ, không dừng lại giữa chừng để xem mình đang đi đúng hướng hay chưa.

Rồi, ở một góc khác của bản đồ AI, nhóm Sapient Intelligence đang tìm cách vẽ lại cách máy tính suy nghĩ. Nếu LLM là tàu tốc hành, thì HRM giống một đoàn leo núi chuyên nghiệp. Trong đội này có hai “thành viên” đặc biệt: module-L thực hiện việc xử lý chi tiết với tốc độ cao, còn module-H chịu trách nhiệm lập kế hoạch trừu tượng với tốc độ chậm hơn.

Nói cách khác, module-L là một kẻ trinh sát linh hoạt, có thể chạy đi chạy lại, điều chỉnh từng bước chân và phản ứng nhanh với các thay đổi thời tiết và địa hình. Trong khi, module-H là một gã thủ lĩnh dày dặn kinh nghiệm, có thể lập kế hoạch đường đi, phân tích địa hình, cân nhắc chiến lược dài hạn để đưa cả đoàn đi tiếp.

Cả hai module phối hợp theo một nhịp điệu riêng: Module-L liên tục lặp nhanh (Fast Iterations) để tinh chỉnh dữ liệu, trong khi Module-H thường xuyên cập nhật chiến lược (Strategy Update) để điều chỉnh hướng đi. Cả hai gặp nhau tại một điểm cân bằng cục bộ (Local Equilibrium), nơi tốc độ và độ an toàn được duy trì hài hòa. Thậm chí các nhà nghiên cứu còn dùng thêm một thuật toán học tăng cường (Q-learning) để làm “trí nhớ kinh nghiệm” cho việc nâng cao chất lượng đầu ra: mỗi bước thành công hay sai lầm đều trở thành bài học cho bước tiếp theo.

Nếu đặt lên bàn cân để so sánh thì sẽ thấy các ưu nhược rõ ràng của từng loại mô hình. LLM mạnh trong tốc độ xử lý khối lượng thông tin khổng lồ, nhưng suy nghĩ theo “một hơi”, không thay đổi chiến lược khi đang xử lý một truy vấn. Ngược lại, HRM chậm hơn ở cấp chiến lược nhưng bù lại có thể thích ứng ngay trong quá trình suy luận, mô phỏng cách con người suy nghĩ: phân tích, thử nghiệm, điều chỉnh, hoàn thiện. Mã nguồn của HRM vừa được công khai trên Github cho cộng đồng theo dõi.

Khả năng tận dụng dữ liệu hiệu quả và suy luận chính xác của HRM cũng mở ra cơ hội mới cho các lĩnh vực vốn thiếu dữ liệu nhưng đòi hỏi độ chính xác cao. Sapient Intelligence tiết lộ rằng họ đang hợp tác với một số viện nghiên cứu y khoa để phát triển các ứng dụng hỗ trợ chẩn đoán y tế, đặc biệt là các trường hợp bệnh hiếm gặp, nơi tín hiệu dữ liệu thưa thớt, khó phát hiện và đòi hỏi suy luận sâu. Ngoài ra, họ cũng thử nghiệm với các mô hình dự báo khí hậu, mà theo tuyên bố đã giúp nâng độ chính xác của các dự báo cận thời vụ đến theo mùa (S2S) lên gần 97%, một bước tiến được đánh giá là sẽ “mang lại giá trị thiết thực cho kinh tế và xã hội”.

Đội ngũ phát triển Sapient HRM bao gồm các cựu nhân viên của Google DeepMind, DeepSeek, Anthropic và xAI, cùng với các nhà nghiên cứu từ Đại học Thanh Hoa, Đại học Bắc Kinh (Trung Quốc), Đại học UC Berkeley (Mỹ), Đại học Cambridge (Anh) và Đại học Alberta (Canada).

Những rủi ro tiềm ẩn

Mặc dù HRM chứng minh rằng kiến trúc có thể đánh bại quy mô, nhưng nó cũng không phải là không có những rủi ro tiềm ẩn.

Trước hết, mô hình HRM vẫn phải đối mặt với vấn đề “hộp đen” liên quan đến khả năng giải thích của AI. Mặc dù Giám đốc Guan Wang của Sapient Intelligence nói rằng mô hình của họ có thể được “giải mã và hình dung”, nhưng các nhà công nghệ vẫn lo ngại về tính chất hộp đen của mô hình này. Hiện tại, HRM cũng chủ yếu chuyên về các nhiệm vụ suy luận cụ thể và vẫn còn hạn chế về tính linh hoạt.

Về mặt quản lý, tính nhẹ và hiệu quả của HRM sẽ đòi hỏi các nhà làm luật xem xét lại những khung pháp lý về AI, vốn được xây dựng dựa trên hiểu biết về các hệ thống AI quy mô lớn sẵn có. Đặc biệt, việc quản lý và giám sát các AI tiên tiến chạy trên thiết bị cá nhân như HRM sẽ tạo ra những thách thức mới.

Lý do là vì các mô hình AI lớn truyền thống thường được lưu trữ trên máy chủ tập trung, với dữ liệu được gửi về trung tâm để xử lý. Do đó, các khung quản lý AI đã được các nhà làm luật phát triển theo hướng quản lý tập trung, nhắm vào một số tác nhân chính như nhà phát triển, nhà nghiên cứu, công ty công nghệ và trung tâm dữ liệu. Tuy nhiên, khả năng chạy trực tiếp trên thiết bị cá nhân của HRM AI sẽ thay đổi toàn bộ mô hình này: điểm kiểm soát sẽ dịch chuyển từ một vài tập đoàn lớn sang hàng triệu thiết bị và người dùng cá nhân.

Rõ ràng, giám sát AI chạy trên thiết bị cá nhân là một thách thức khổng lồ. Làm thế nào để ta có thể theo dõi những gì AI đang làm trên điện thoại của mỗi người? Việc kiểm tra hoặc thực thi các quy tắc giám sát sẽ khó hơn nhiều khi hoạt động của AI là riêng tư cho từng thiết bị. Đây không chỉ là vấn đề kỹ thuật, mà còn là một phép thử về cách xã hội cân bằng giữa quyền riêng tư, trách nhiệm pháp lý và hiệu quả công nghệ - và chính những cân nhắc này sẽ định hình hướng phát triển bền vững của AI trong tương lai.

Có thể, vài năm nữa khi nhìn lại, giới AI sẽ nhận ra bước ngoặt không nằm ở việc “nuôi” mô hình lớn hơn, mà ở việc “dạy” cho chúng một kiến trúc thông minh hơn nơi tốc độ, khả năng thích ứng và chiều sâu lý luận cùng tồn tại trong một hệ thống gọn gàng. Về lâu dài, cách tiếp cận này có thể là khởi đầu của một cuộc cách mạng hiệu quả trong ngành AI, và mở đường cho những thay đổi pháp lý đầy thách thức nhưng cân bằng hơn.

Bài đăng KH&PT số 1358 (số 34/2025)